Foundry IQ: a camada de conhecimento dos agentes no Microsoft Foundry - Parte 2

Na Parte 1, montamos a fundação do cenário da Contoso Software: subimos os recursos (Foundry, Storage Account e Azure AI Search), indexamos documentos de SLA no Blob Storage e criamos uma knowledge base no Azure AI Search para habilitar o agentic retrieval via Foundry IQ, deixando o conhecimento pronto para ser consumido de forma padronizada.

Leia a parte 1!

Agora, na Parte 2, o objetivo é dar o próximo passo natural: integrar o knowledge base criada na parte 1 a um agente criado no novo portal do Microsoft Foundry, consumindo tudo via Foundry IQ.

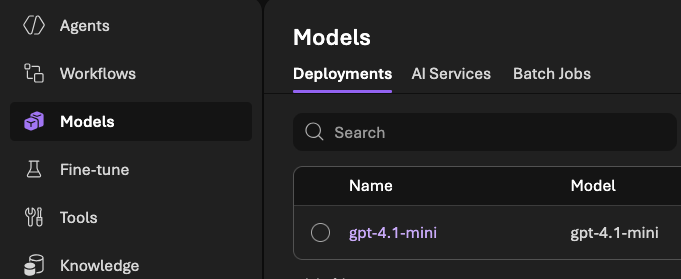

Com isso em mente, vamos entrar no portal do Microsoft Foundry (https://ai.azure.com) e, antes de tudo, garantir que o modelo gpt-4.1-mini está criado e pronto para uso no projeto, já que ele será o modelo principal do agente nesse post.

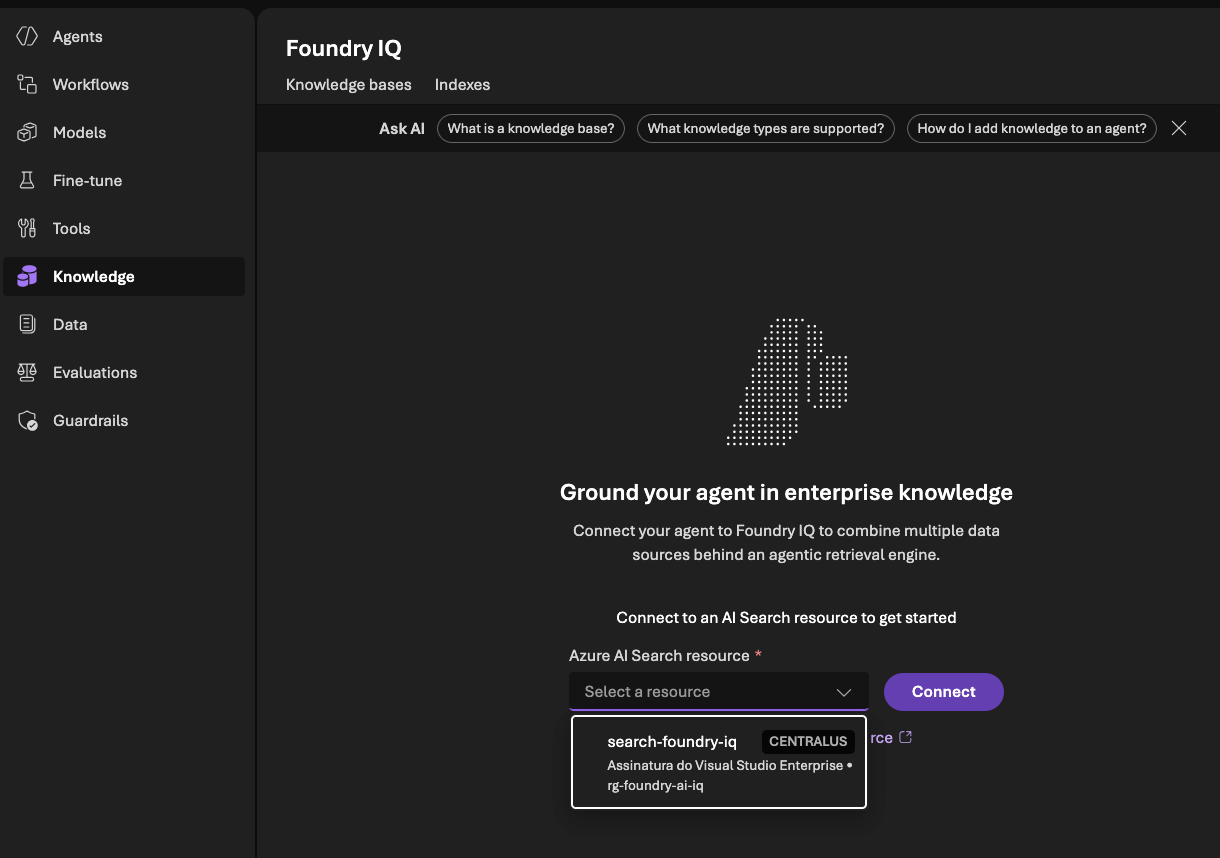

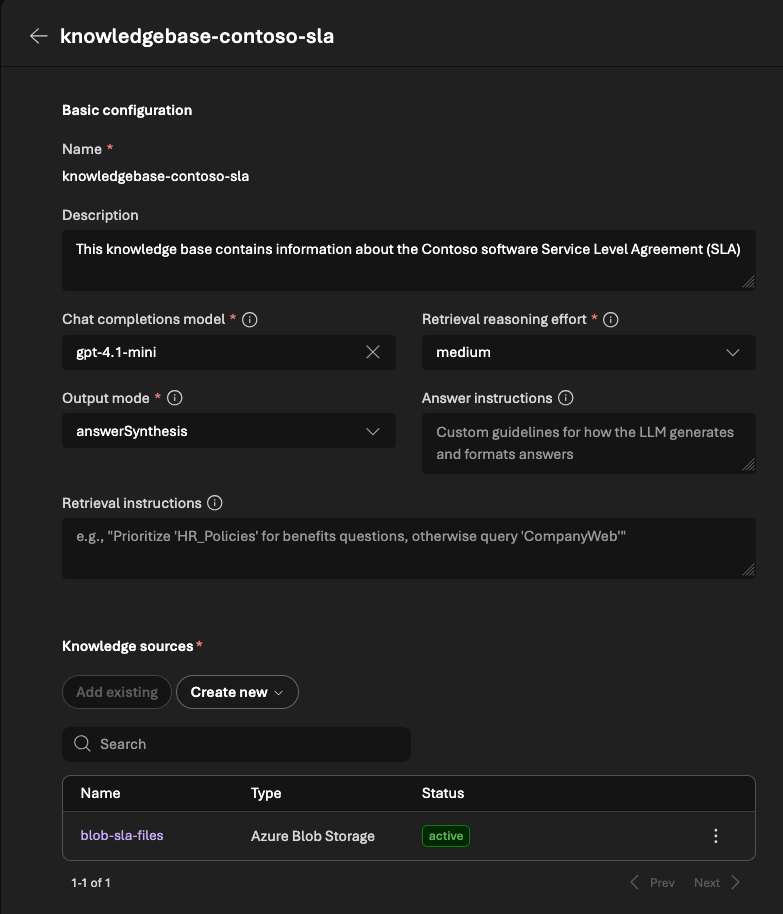

Com o modelo validado, seguimos para a aba Knowledge. É aqui que conectamos o recurso de Azure AI Search ao projeto, permitindo que o Foundry enxergue a knowledge base que criamos no serviço de busca.

Vamos clicar para conectar um novo Azure AI Search e selecionar o mesmo recurso provisionado na parte 1:

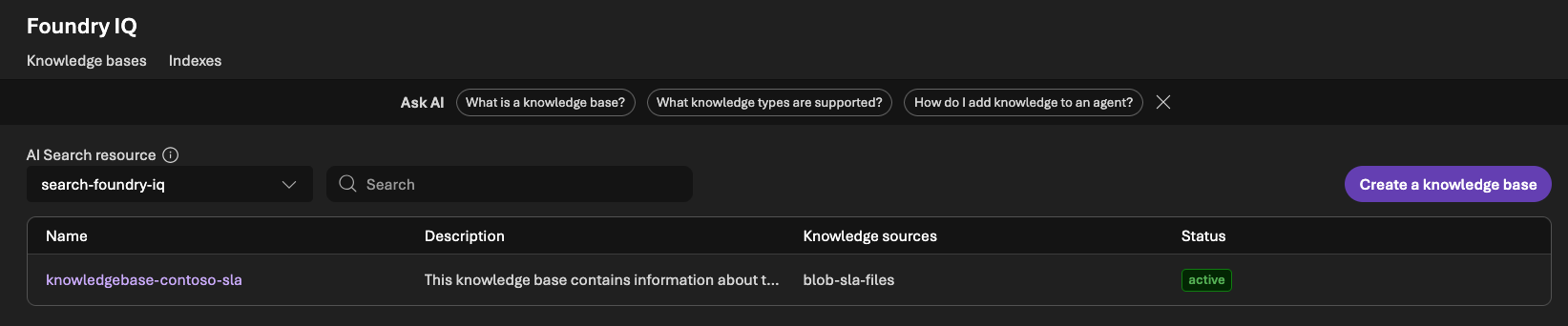

Após a conexão, já conseguimos validar o resultado: a knowledge base deve aparecer importada corretamente, e com acesso a apenas uma knowledge source, que, no nosso post, corresponde aos documentos ingeridos a partir do Azure Blob Storage.

Esse é um ponto importante, porque deixa explícito o “contrato” do conhecimento: o agente não acessa fontes arbitrárias; ele acessa apenas aquilo que foi definido via knowledge base.

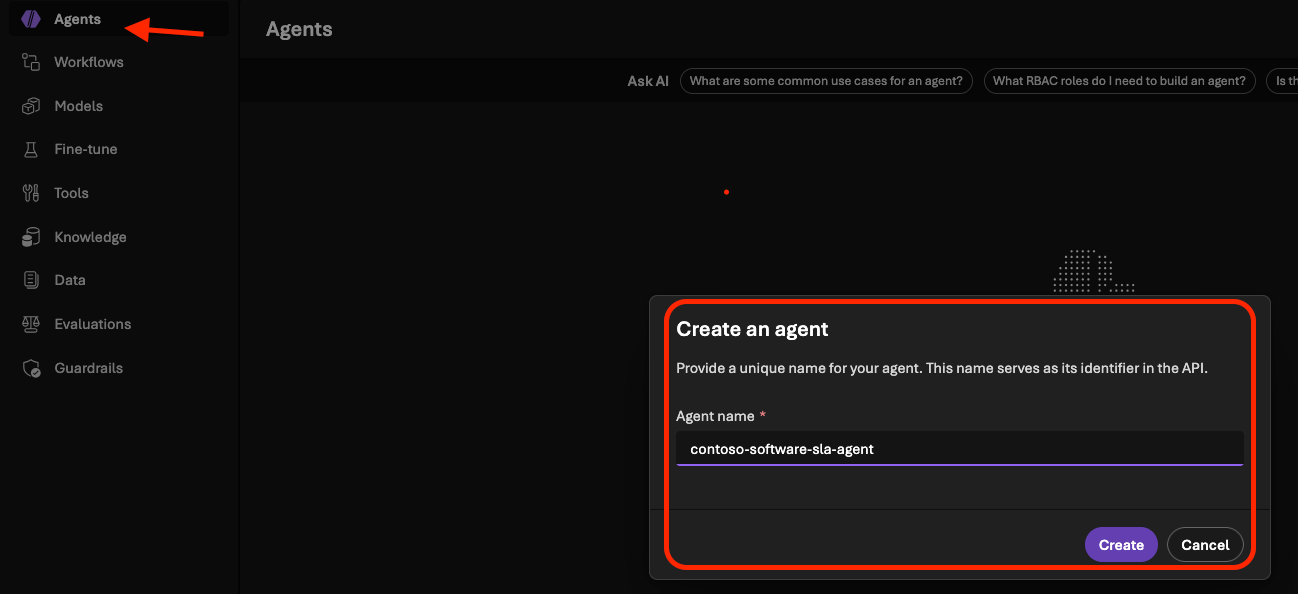

Com a camada de conhecimento conectada, podemos criar o agente no Microsoft Foundry:

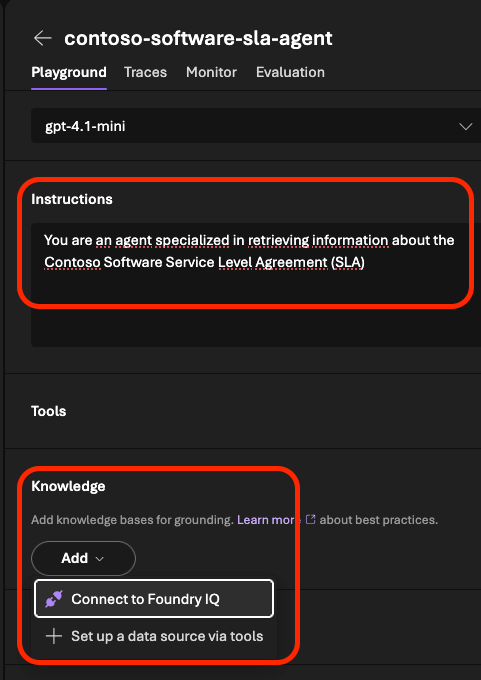

No fluxo de criação, selecione o gpt-4.1-mini e configure instruções objetivas para o cenário: o agente atua como assistente de suporte/operações da Contoso Software e deve responder perguntas sobre classificação de severidade e tempos de resposta (SLA), utilizando sempre a base de conhecimento conectada para embasar as respostas.

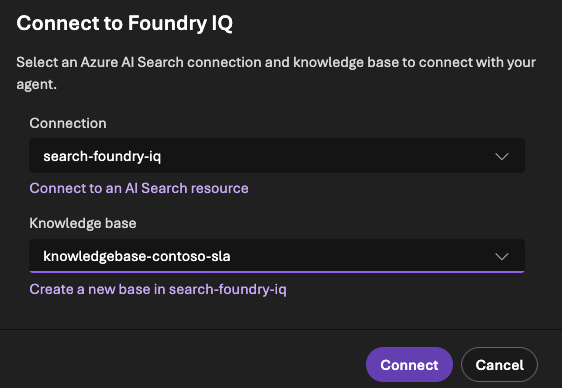

O passo central aqui é vincular o agente ao conhecimento via Foundry IQ. Para isso, vamos selecionar a conexão do AI Search Resource adicionada no passo anterior e, em seguida, escolher a Knowledge Base correta.

Com o agente criado, já podemos iniciar uma conversa diretamente no portal e repetir a mesma pergunta usada na parte 1, para comparar o comportamento:

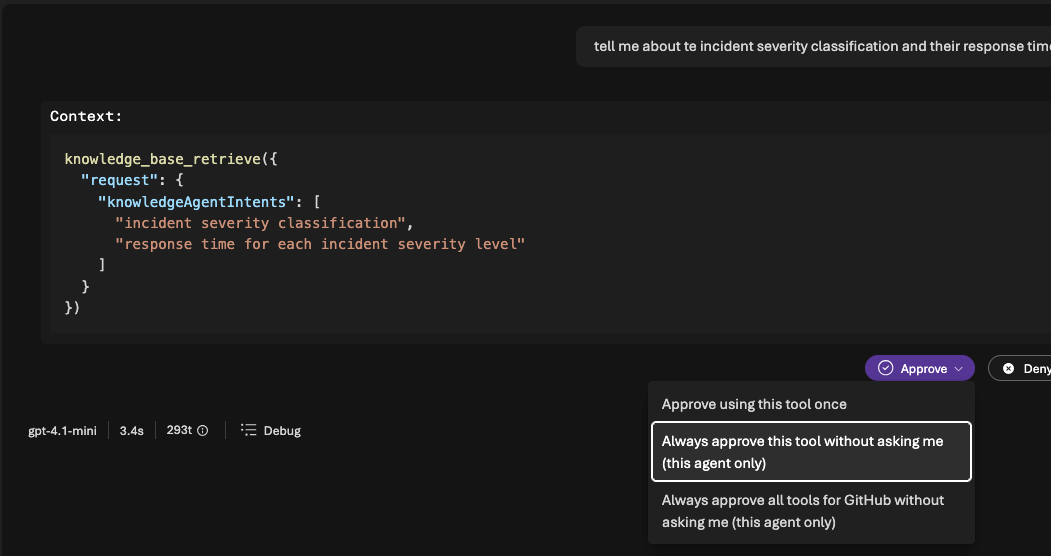

tell me about te incident severity classification and their response time

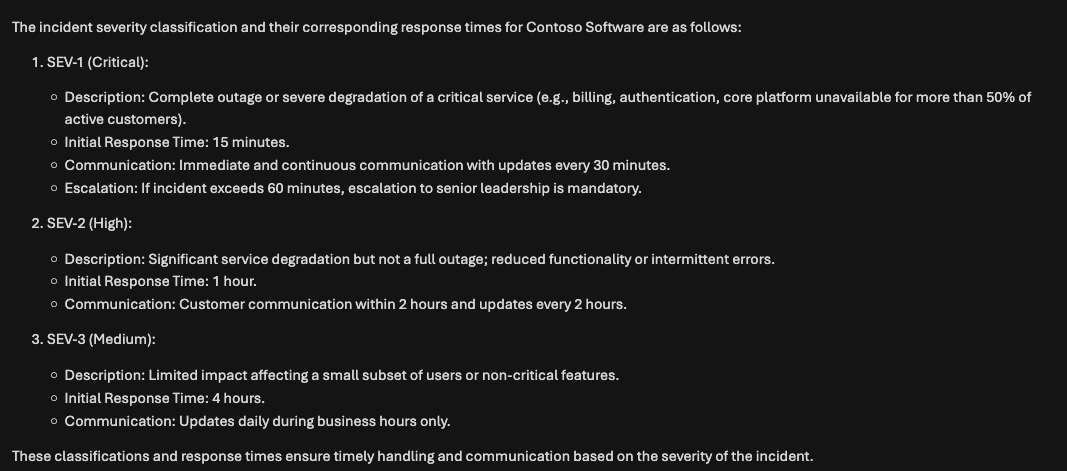

Em seguida, teremos a resposta do agente:

Um ponto interessante é observar que o conteúdo retornado tende a ser bastante semelhante ao obtido na parte 1, e isso é esperado, já que estamos consumindo a mesma knowledge base. O que muda aqui é o formato de consumo: antes testamos o retrieval no contexto da base; agora temos um agente usando essa base como “camada de conhecimento” em um fluxo mais próximo de aplicações de mundo real.

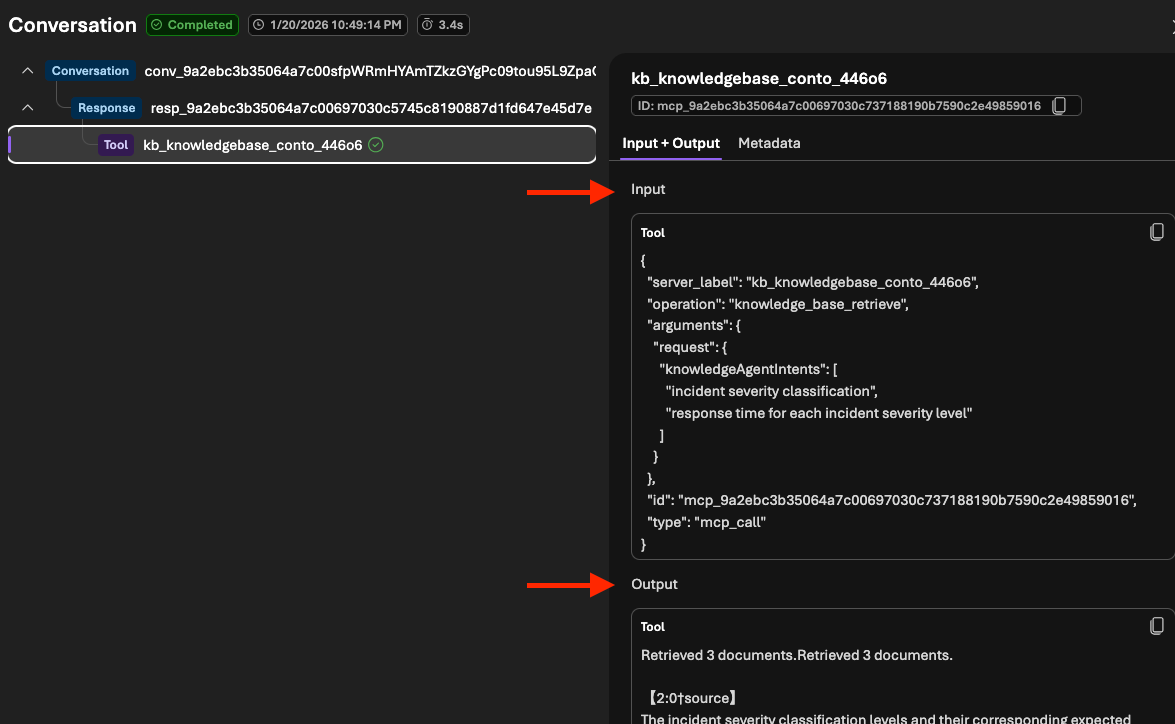

Agora vamos clicar em Debug. É nesse modo que conseguimos ver claramente que a chamada do agente à knowledge base é feita via MCP, como mostrado abaixo:

O payload deve ser semelhante ao seguinte:

{

"server_label": "kb_knowledgebase_conto_446o6",

"operation": "knowledge_base_retrieve",

"arguments": {

"request": {

"knowledgeAgentIntents": [

"incident severity classification",

"response time for each incident severity level"

]

}

},

"id": "mcp_9a2ebc3b35064a7c00697030c737188190b7590c2e49859016",

"type": "mcp_call"

}Repare que, em vez de uma busca única e direta, o agente aciona a knowledge base com base em intenções. Isso conversa diretamente com o conceito de agentic retrieval: decompor a pergunta, buscar evidências de forma mais orientada a objetivo e então consolidar um contexto melhor ranqueado para responder.

Na sequência, o próprio debug também expõe parte do retorno vindo do Foundry IQ, por exemplo:

Retrieved 3 documents.Retrieved 3 documents.

【2:0†source】

The incident severity classification levels and their corresponding expected response times are as follows:

- SEV-1 (Critical): Represents a complete outage or severe degradation of a critical service. The initi ...E aqui fechamos a parte 2! Fiquem ligados para mais!

Você já pode baixar o projeto por esse link, e não esquece de me seguir no LinkedIn!

Até a próxima, abraços!